Die modernen, datenbasierten Umgebungen (Training von KI-Modellen und Echtzeit-Prognoseanalysen) sind hinsichtlich ihres Bedarfs an Rechenleistung unvergleichlich. Herkömmliche Server-Systeme neigen dazu, langsam und träge zu sein, was zu Staus, langen Verarbeitungszeiten und hohen Betriebskosten führt. Dies ist eine der Ursachen für Ineffizienzen in Unternehmen der Finanz-, Fertigungs- und Energiewirtschaft, wo Geschwindigkeit und Genauigkeit direkt die Wettbewerbsfähigkeit bestimmen. Einführung Open Accelerator Module (OAM) GPU-Server : Dies ist ein speziell entwickeltes Produkt, und Aethlumis nutzt seine engen Beziehungen zu Branchengrößen wie HPE, Dell und Huawei, um diese hochmodernen Komponenten auf den Markt zu bringen.

Die Schwächen herkömmlicher GPU-Server-Architekturen.

Bevor man fortfährt, um die Vorteile von OAM nutzen zu können, sollte bekannt sein, warum herkömmliche GPU-Server für KI-Arbeitslasten nicht geeignet sind. Die traditionellen Architekturen, die üblicherweise PCIe-basierte Grafikkarten verwenden, weisen einige inhärente Einschränkungen auf, wie beispielsweise begrenzte Bandbreite zwischen den Grafikkarten und den Zentralprozessoren, einen starren Formfaktor, der eine Skalierung erschwert, sowie eine schlechte thermische Leistung bei intensiven Betriebsbedingungen.

Bedeutende Vorteile von OAM-GPU-Servern für die Produktivität von KI.

OAM-GPU-Server schließen diese Lücken mit einem innovativen Design, das auf drei grundlegenden Säulen basiert, welche die Effizienz fördern:

Hochbandbreiten-Interconnects zur Beschleunigung des Datenverkehrs.

OAM verwendet Interconnect-Technologien der aktuellen Generation (z. B. NVLink und OpenCAPI), um die Einschränkungen des PCIe-Busses zu umgehen, wodurch eine Hochgeschwindigkeits-Punkt-zu-Punkt-Kommunikation zwischen GPUs und anderen Chips ermöglicht wird. Dies führt zu einer erheblichen Verringerung der Latenz bei der Datenübertragung, was für KI-Arbeitslasten, die auf dem Transfer umfangreicher Datensätze zwischen Verarbeitungseinheiten beruhen, äußerst wichtig ist. Am Beispiel eines Deep-Learning-Modells, das mit Bilddaten trainiert wird, kann die Geschwindigkeit auf OAM-Servern um 30–40 Prozent höher liegen, da hier keine Engpässe beim Zugriff der GPUs auf Trainingsdaten auftreten. Durch die Kombination von OAM und Hardware von Anbietern wie HPE, Dell und Huawei wird Aethlumis sicherstellen, dass diese Interconnects untereinander sehr gut kompatibel sind, und Kompatibilitätsprobleme, die oftmals vorgefertigte Lösungen problematisch machen, werden eliminiert.

Bedarfsgerechte Skalierbarkeit entsprechend den Anforderungen der Arbeitslast.

Die Projekte im Bereich KI sind nicht abgeschlossen – Unternehmen können mit der Erprobung eines kleinen Modells beginnen und nachts die Abdeckung auf die gesamte Organisation ausweiten. Das modulare OAM-Design ermöglicht es Organisationen, die Serverinfrastruktur durch Hinzufügen und Aufrüsten von GPUs, Speicher und Speicherkapazität zu erweitern, ohne unbedingt ein vollständiges Upgrade durchführen zu müssen. Diese Flexibilität bedeutet, dass Unternehmen nur in die Ressourcen investieren müssen, die sie aktuell benötigen, und später hochskalieren können, falls die Workloads bei KI-Prozessen ansteigen. Für Kunden aus dem Energiesektor, die Netzdaten zur Steuerung der Verteilung erneuerbarer Energien nutzen müssen, ist dies bahnbrechend: Sie können mit einer kleinen OAM-Architektur starten und diese mit wachsendem Datenaufkommen erweitern, ohne von Anfang an überdimensioniert zu planen und dabei minimale Kosten verursachen.

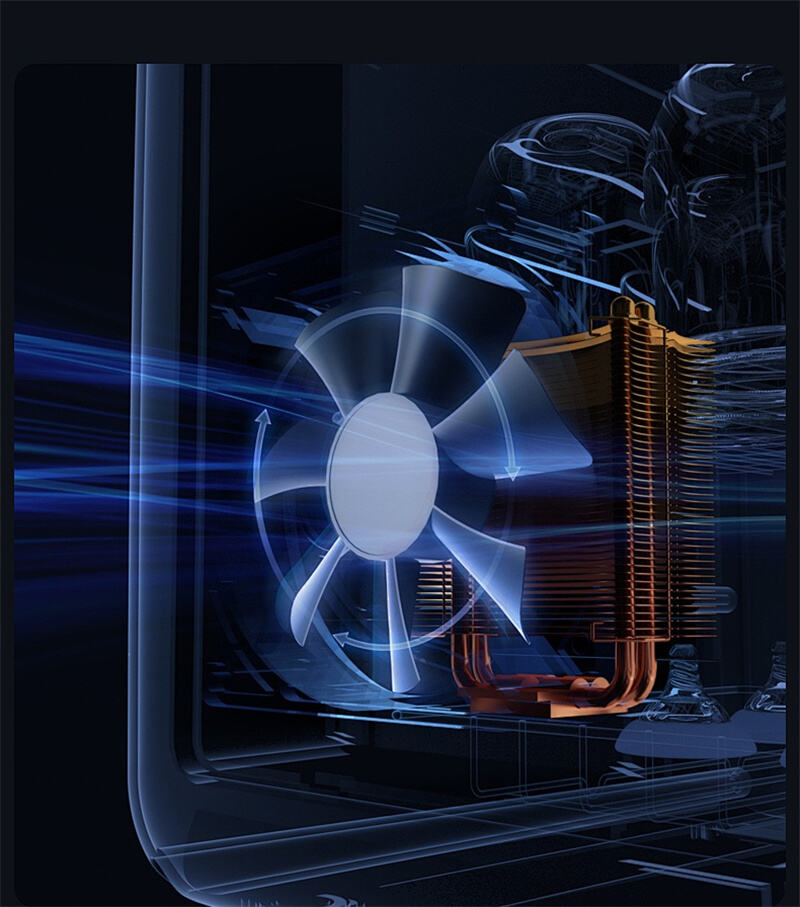

Leistungs- und thermisch optimierter Verbrauch.

Die geladene KI erzeugt eine hohe Last für den Server, wodurch viel Wärme entsteht, die die Leistung beeinträchtigen und mehr Energie verbrauchen kann. OAM-Server können leicht thermisch gesteuert werden, einschließlich eines verbesserten Luftstromdesigns und einer direkten Flüssigkeitskühlung, wodurch die Komponenten stets bei idealen Temperaturen gehalten werden. Dadurch wird nicht nur die Zuverlässigkeit erhöht, sondern auch der Stromverbrauch reduziert: Die von Aethlumis entwickelten OAM-Lösungen als Verkörperung grüner Technologie benötigen nur bis zu 25 Prozent der Leistung, die ein herkömmlicher Server mit Grafikkarte für dieselbe KI-Aufgabe benötigen würde. Dies bedeutet, dass bei Produktionsstätten, die über rund um die Uhr laufende KI-Qualitätskontrollsysteme verfügen, die Energiekosten minimiert und der CO₂-Fußabdruck verringert werden.

Branchenspezifischer Effekt: Branchenspezifische OAM-Lösungen von Aethlumis.

Die Tatsache, dass Aethlumis Erfahrung im Bereich der Betreuung der Finanz-, Fertigungs- und Energieindustrie besitzt, stellt sicher, dass OAM-GPU-Server nicht nur hochtechnisch, sondern auch branchenspezifisch sind:

Finanzen: OAM verfügt über eine geringe Latenz, um die Echtzeitverarbeitung von Marktdaten zur Unterstützung algorithmischer Handelsstrategien, Risikomodellierung und anderer Anwendungen zu ermöglichen, wodurch Unternehmen in Sekundenbruchteilen Entscheidungen treffen können, ohne gegen regulatorische Anforderungen zu verstoßen. Die sichere Integration von Aethlumis gewährleistet, dass vertrauliche Finanzdaten während der KI-Berechnungen nicht verloren gehen.

Fertigung: KI in der Fertigung kann zur vorausschauenden Wartung und Optimierung der Produktion eingesetzt werden, was auf der Verarbeitung großer Mengen von Sensordaten basiert. Die OAM-Server reduzierten die Datenverarbeitungszeit von Stunden auf wenige Minuten, wodurch Hersteller Ausfallzeiten minimieren und den Durchsatz maximal erhöhen konnten. Dies wurde durch die zeitnahe technische Unterstützung von Aethlumis bei der Behebung jeglicher Betriebsprobleme ermöglicht.

Energie: Die Optimierung des Stromnetzes und die Prognose erneuerbarer Energien erfordern den Umgang mit variablen und sehr großen Datenmengen. Die Skalierbarkeit von OAM ermöglicht es Energieunternehmen, Schwankungen in der Datenlast zu bewältigen, während seine Effizienz dazu beiträgt, dass Energie grüner wird – ein Aspekt, der angesichts des zunehmenden Interesses an grüner Technologie immer wichtiger ist.

Zusammenfassung: OAM-GPU – Der Sprungbrett für den KI-Erfolg.

OAM-GPU-Server auf der Welt, wo die Effektivität von KI direkt von der Reaktionsfähigkeit des Unternehmens abhängt, stellen eine transformative Lösung dar. Sie bieten eine Antwort darauf, wie das Potenzial von KI-Projekten in Organisationen erschlossen werden kann, indem sie deren Anforderungen hinsichtlich Bandbreite, Skalierbarkeit und Energieverbrauch adressieren. Aethlumis hat außerdem Partnerschaften mit HPE, Dell und Huawei geschlossen, um sicherzustellen, dass diese hochwertigen Server mit der Zuverlässigkeit, Sicherheit und technischen Unterstützung angeboten werden, die Kunden aus den Bereichen Finanzen, Fertigung und Energie benötigen könnten. Die OAM-GPU-Server sind nicht nur ein Hardware-Upgrade, da die KI-Arbeitslasten zunehmend anspruchsvoller werden, sondern eine Investition in die Zukunft der rechnerischen Effizienz.

Inhaltsverzeichnis

- Die Schwächen herkömmlicher GPU-Server-Architekturen.

- Hochbandbreiten-Interconnects zur Beschleunigung des Datenverkehrs.

- Bedarfsgerechte Skalierbarkeit entsprechend den Anforderungen der Arbeitslast.

- Leistungs- und thermisch optimierter Verbrauch.

- Branchenspezifischer Effekt: Branchenspezifische OAM-Lösungen von Aethlumis.

- Zusammenfassung: OAM-GPU – Der Sprungbrett für den KI-Erfolg.