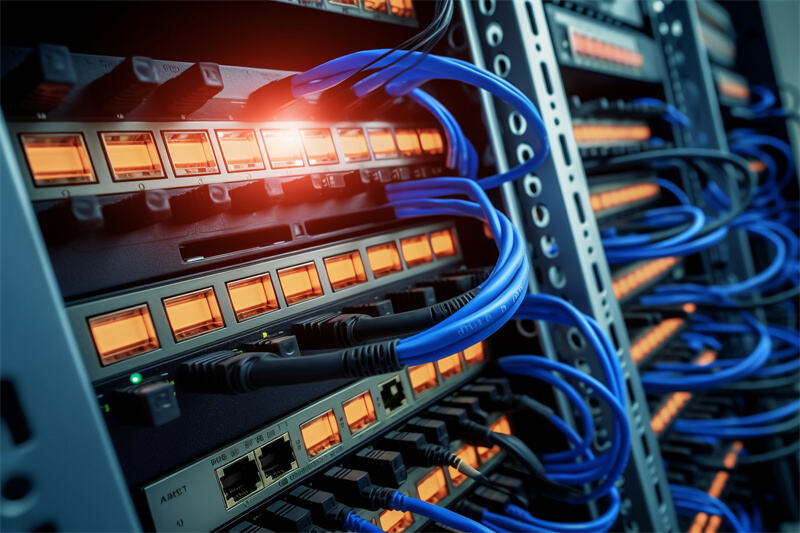

Vi står også i færd med at implementere avanceret infrastruktur inden for kritiske områder hos Aethlumis gennem vores tætte samarbejde med globale teknologiledere såsom HPE, Dell og Huawei. Der findes én arkitektonisk teknologi inden for kunstig intelligens, som har blevet afgørende for opbygningen af de supercomputersystemer, der driver AI i dag: den OAM (Open Accelerator Module) GPU-server . Dette er ikke bare en anden type hardware, men rygraden, hvorpå skala, ydelse og effektivitet for de mest krævende AI-arbejdsbelastninger i vores tid bygges.

Standardisering og densitetsdrev.

Den enorme størrelse på AI-modeller, især store sprogmodeller (LLMs) og mere komplekse neurale netværk, har gjort den gammeldags serverarkitektur, der var beregnet til brug med enklere modeller, uhensigtsmæssig. Modellerne kræver et hidtil uset niveau af parallel databehandling, hvilket igen kræver, at dusinvis – og nogle gange hundreder – af GPU'er integreres sammen i et system. OAM er en vigtig åben standard, som er et åbent system, der adskiller GPU-akseleratoren fra dens proprietære formfaktor. Denne standardisering, der blev indført af branchekonsortier, muliggør, at leverandører som NVIDIA, AMD og andre kan udvikle ydeevneoptimerede GPU'er, der kan monteres i en standardiseret, strømlinet kabinetløsning. For vores kunder inden for finans, produktion og energi betyder det, at de kan opbygge store og højtydende datamaskinclusters uden at være bundet til et enkelt vendors økosystem, hvorved de sikrer fleksibilitet og fremtidssikrer deres investeringer.

Overvinde flaskehalsen i forbindelser.

Der er ingen nytte ved rå regnekraft, der ikke kan kommunikere i ekstraordinære hastigheder, som GPU'erne. Selv en enkelt server med et par GPU'er kan ikke bruges til at træne en model med trillioner af parametre. Den egentlige genialitet i OAM-arkitekturen er, at den kombineres med ekstremt højhastigheds- og lav-latens-forbindelsesnetværk såsom NVLink og NVSwitch (i NVIDIA-økosystemet) eller tilsvarende løsninger. OAM-servere er specifikt implementeret til at understøtte direkte kommunikation mellem GPU'erne i hele rack-modulet uden at involvere langsommere traditionelle PCIe-stier. Dette skaber en kæmpestor enkelt accelerator, hvor terabytes af simuleringsdata kan udveksles næsten i realtid. Det er netop dette, der gør, at en samling computere med individuelle komponenter bliver til en ægte, monolitisk AI-supercomputer. Det muliggør direkte og præcist levering af projekter, hvilket ellers ikke ville være muligt at opnå.

Termisk og strømteknisk design: Skalateknik

Den store effekttæthed i et enkelt rack stiller betydelige krav til termisk håndtering og strømforsyning. OAM-serveren er ikke blot en kasse med GPU'er: Den er et systemteknisk mesterværk, der tager højde for langvarig ydelse. Disse systemer er designet med avancerede og koordinerede kølesystemer, typisk direkte chip-køling med væske, som effektivt kan afledes varme ved effektforbrug på op til flere kilowatt. Dette sikrer, at GPU'erne kan vedligeholde boost-clock over længere perioder, hvilket er uvurderligt under træningsprogrammer, der varer uger. Desuden sikrer den integrerede strømdesign stabil og ren strømforsyning i stor skala. Det resulterer i pålidelighed og mindre risiko for nedetid for vores kunder ved kritiske, langvarige AI-træningsprocesser eller storskala inferensoperationer.

Skalerbarheden af kunstig intelligens.

Endelig er OAM-formfaktoren den skalerbare enhed for AI-infrastruktur. Den gør det muligt for datacentre at skifte til en scale-out-tilgang i acceleration i stedet for scale-up. En pod kan samles ved at forbinde individuelle OAM-moduler, og en supercomputerkluster kan samles ved at forbinde pods. Vores erfaring med systemintegration sammen med vores partnere, såsom HPE og Huawei, giver os mulighed for at tilbyde denne modularitet, så organisationer kan udvikle deres AI-evner trin for trin og efter behov. Det leverer den ydelse og pålidelighed, som kræves af følsomme industrielle og finansielle AI-applikationer – fra generativ AI og realtidsbedragsbekæmpelse til komplekse digitale tvillinger og simulationer af prediktiv vedligeholdelse.

Afgørende repræsenterer OAM GPU-servere ikke blot en opgradering. De udgør et paradigmeskift i datacenterdesign og er specifikt udviklet med det formål at overvinde de særlige flaskehalse inden for AI-supercomputing. De tilbyder de tre grundlæggende ingredienser: standardiseret densitet, gennembrud i interconnectivitet og effektiv termisk styring, hvilket skaber det urokkelige fundament, hvorpå fremtiden for kunstig intelligens bygges. Vi bruger vores alliancer og tekniske ekspertise til at levere og vedligeholde denne underliggende infrastruktur hos Aethlumis, så vores kunder i finans-, produktions- og energisektoren kan udvikle innovationer effektivt og med tillid.