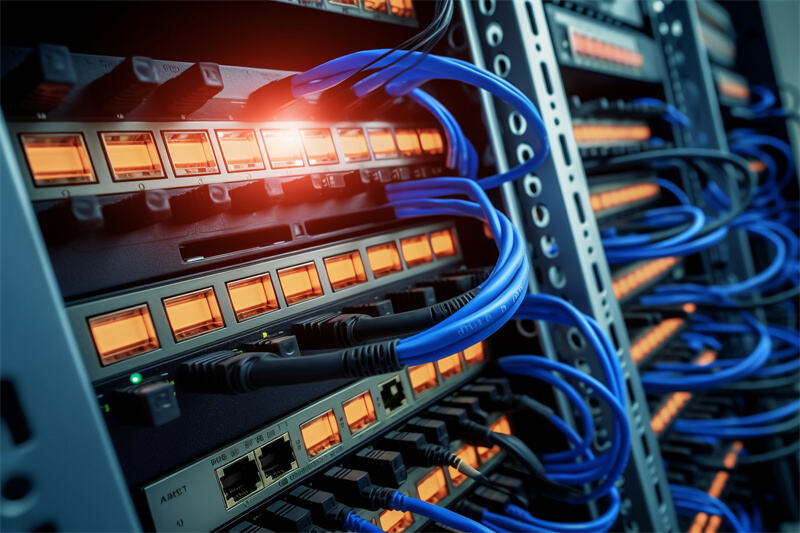

Jesteśmy również na krawędzi wdrażania zaawansowanej infrastruktury w kluczowych obszarach w Aethlumis dzięki naszym bliskim relacjom z globalnymi liderami technologicznymi, takimi jak HPE, Dell i Huawei. Istnieje jedna technologia architektoniczna w dziedzinie sztucznej inteligencji, która stała się niezbędna przy budowie systemów superkomputerowych napędzających współczesną sztuczną inteligencję: Serwer GPU OAM (Open Accelerator Module) nie jest to kolejny sprzęt, lecz podstawa, na której oparte są skala, wydajność i efektywność najbardziej wymagających obciążeń AI naszych czasów.

Standardyzacja i gęstość montażu.

Ogromna skala modeli sztucznej inteligencji, w szczególności dużych modeli językowych (LLM) i bardziej złożonych sieci neuronowych, sprawiła, że tradycyjna architektura serwerów zaprojektowana do pracy z prostszymi modelami stała się niewykonalna. Modele te wymagają niebywałej ilości mocy przetwarzania równoległego, co z kolei wymaga integracji dziesiątek, a czasem nawet setek GPU w spójny system. OAM to ważny otwarty standard, który stanowi otwarty system oddzielający akcelerator GPU od jego własnej formy fizycznej. Ta standaryzacja, inicjowana przez konsorcja branżowe, pozwala dostawcom takim jak NVIDIA, AMD i innym na rozwijanie wysokowydajnych GPU, które mogą być montowane w standardowych, zoptymalizowanych obudowach. Dla naszych klientów z sektorów finansowego, przemysłowego i energetycznego oznacza to możliwość tworzenia dużych klastrów obliczeniowych o wysokiej wydajności bez uzależnienia od ekosystemu jednego dostawcy, co daje im elastyczność i gwarantuje przyszłościową ochronę ich inwestycji.

Pokonanie wąskiego gardła w połączeniach.

Nie ma sensu dysponować surową mocą obliczeniową, która nie może komunikować się z niesamowitą prędkością, czyli GPU. Nawet pojedynczy serwer z kilkoma kartami GPU nie pozwala na trenowanie modelu o trylionie parametrów. Prawdziwym przebłyskiem geniuszu architektury OAM jest jej połączenie z ultra-szybkimi i o niskim opóźnieniu strukturami łącznościowymi, takimi jak NVLink i NVSwitch (w ekosystemie NVIDIA) lub ich odpowiednikami. Serwery OAM są specjalnie zaprojektowane tak, aby wspierać bezpośrednią komunikację między kartami GPU we wszystkich modułach w szafie, pomijając wolniejsze, tradycyjne ścieżki PCIe. To tworzy ogromny, pojedynczy akcelerator, w którym terabajty danych symulacyjnych mogą być przesyłane praktycznie w czasie rzeczywistym. To właśnie sprawia, że zestaw oddzielnych komputerów staje się prawdziwym, monolitycznym superkomputerem AI. Umożliwia on bezpośrednią, terminową realizację projektów, której bez tego nie byłoby możliwe osiągnięcie.

Projektowanie termiczne i energetyczne: inżynieria w skali.

Duża gęstość mocy w pojedynczej szafie stwarza znaczące problemy termiczne i energetyczne. Serwer OAM to nie tylko obudowa GPU: to arcydzieło inżynierii systemowej, które skupia się na długoterminowej wydajności. Te systemy są projektowane z zaawansowanymi i zsynchronizowanymi systemami chłodzenia, zazwyczaj chłodzeniem cieczowym bezpośrednim do chipu, które skutecznie odprowadza ciepło przy poborze mocy sięgającym kilowatów. Ma to na celu umożliwienie GPU utrzymywania zegarów turbo przez długie okresy, co jest niezbędne w programach treningowych trwających tygodniami. Co więcej, zintegrowany projekt zasilania zapewnia stabilne, dużoskalowe i czyste zasilanie. Przekłada się to na niezawodność oraz mniejsze ryzyko przestojów u klientów podczas krytycznych, długotrwałych operacji szkolenia AI lub dużych operacji wnioskowania.

Skalowalność Sztucznej Inteligencji.

Wreszcie form-factor OAM jest jednostką skalowalnej infrastruktury AI. Umożliwia przekształcenie akumulacji centrów danych w podejście typu scale-out zamiast scale-up w zakresie przyspieszania. Pula może zostać złożona poprzez łączenie poszczególnych modułów OAM, a klaster superkomputerowy może zostać utworzony przez łączenie pool. Nasze doświadczenie w integracji systemów z partnerami, takimi jak HPE i Huawei, pozwala nam oferować tę modularność, umożliwiając organizacjom rozwijanie możliwości AI w bardzo efektywny, etapowy sposób dostosowany do ich potrzeb. Zapewnia wydajność i niezawodność wymagane przez wrażliwe aplikacje przemysłowe i finansowe wykorzystujące sztuczną inteligencję, obejmujące od sztuki generatywnej i wykrywania oszustw w czasie rzeczywistym po złożone cyfrowe bliźniaki oraz symulacje predykcyjnego utrzymania ruchu.

Bezapelacyjnie serwery OAM GPU nie stanowią jedynie ulepszenia. Reprezentują zmianę paradygmatu w projektowaniu centrów danych i zostały zaprojektowane z wyraźnym celem przezwyciężenia konkretnych wąskich gardeł w zakresie superkomputerów AI. Ofertują trzy podstawowe składniki: ustandaryzowaną gęstość, przełomową łączność oraz skuteczne zarządzanie temperaturą, które tworzą niezłomne podstawy, na których budowana jest przyszłość sztucznej inteligencji. Wykorzystujemy nasze sojusze i wiedzę techniczną, aby dostarczać i utrzymywać tę podstawową infrastrukturę w Aethlumis, umożliwiając naszym klientom z branż finansowej, przemysłowej i energetycznej innowacje w sposób efektywny i pewny siebie.